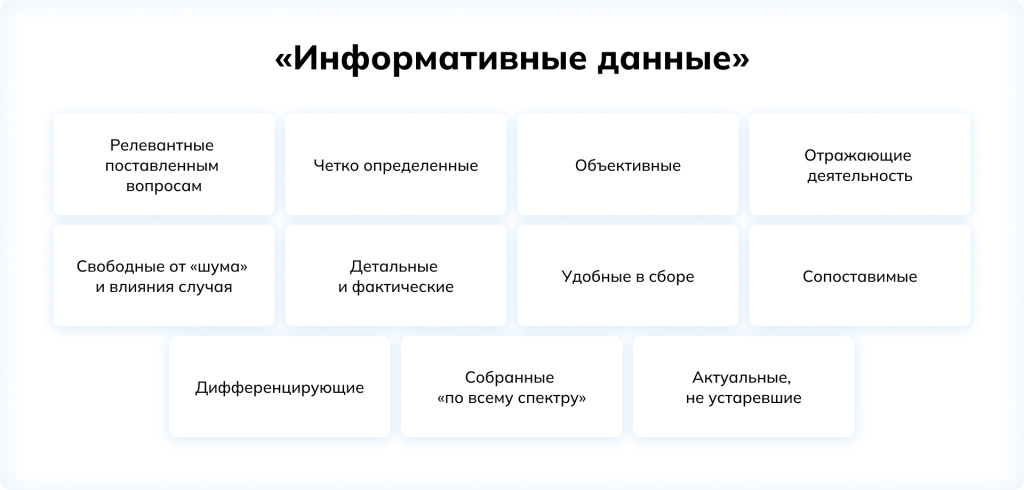

Данные должны быть релевантными, то есть в целом относящимися к рассматриваемому процессу. Данные должны быть четкими и однозначными. Данные должны быть объективными, отражающими рабочую деятельность, свободными от «шума» и влияния случая. Они должны быть детальными и фактическими, удобными для сбора и сопоставимыми, иллюстрирующими весь спектр эффективности, дифференцирующими людей и актуальными...

Многие из этих требований вытекают, по большому счету, из соображений здравого смысла и не требуют дополнительных разъяснений. Другие, к примеру, необходимость собирать данные не только по «самым лучшим» людям, связаны с общепринятой позитивистской методологией поиска закономерностей. Чтобы проверить гипотезу о том, что между двумя параметрами есть взаимосвязь, мы просто не можем ограничиться исследованием, например, только тех случаев, когда один из этих параметров принимает высокие значения: нужно посмотреть и на другие «возможности». То есть, к примеру, тот факт, что самые успешные сотрудники отлично справляются с каким-то тестом, еще не говорит о его предсказательной силе: чтобы судить об этом, критически важно установить различия между результатами «более успешных» и «менее успешных».

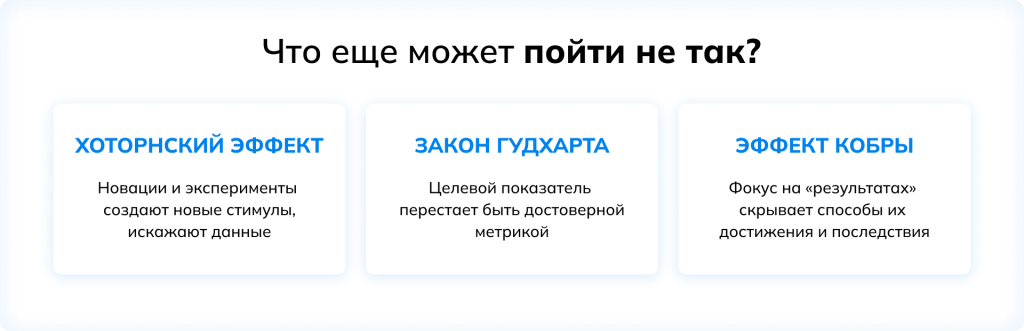

Что еще может пойти не так?

Но даже если все эти требования соблюдены, перед исследователем может возникнуть еще несколько важных проблем.

Один из самых известных вариантов возможного искажения данных носит название Хоторнского эффекта. Он был описан около ста лет назад по итогам серии организационно-психологических экспериментов, показавших, что сам факт наблюдения и сбора данных, касающихся производительности труда, может приводить к систематическому изменению поведения людей, в основном в сторону повышения измеряемых показателей. (Впрочем, стоит отметить, что эти эксперименты все еще остаются предметом бурных споров, и в научной литературе встречается множество интерпретаций и объяснений обнаруженных закономерностей).

Как этот эффект может проявляться в рамках процессов оценки персонала в современной организации, использующей актуальные психометрические инструменты? Дело в том, что любой новый способ, метод или инструмент сбора данных – не важно, внутри организации или снаружи – это некое новое «наблюдение», которое так или иначе создает для сотрудников новые поведенческие стимулы.

Другой возможный сценарий значительного искажения данных описывается законом Гудхарта (по сути, он тоже имеет дело с проблемой непредвиденных стимулов, хотя и под совсем другим углом зрения). Этот закон гласит, что любой критерий перестает быть достоверной метрикой (т.е. количественным параметром, точно отражающим реальность), как только становится целевым. На первый взгляд, это утверждение противоречит всему опыту управления, накопленному человечеством: любая организация использует количественные показатели для постановки целей, мониторинга деятельности и контроля результатов, и эти показатели приносят несомненную пользу, ведь эффективное управление невозможно без измерений.

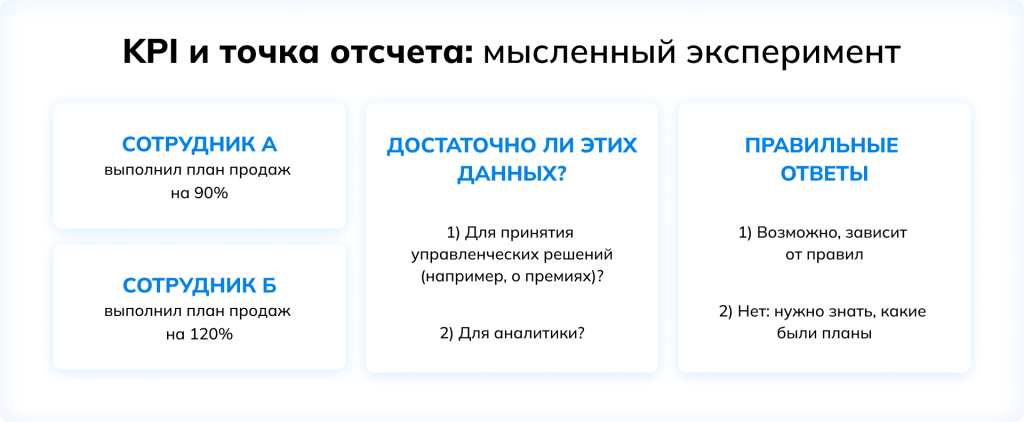

Все это, безусловно, правда. Но есть нюанс. Когда какой-то из параметров объявляется целевым – грубо говоря, превращается в KPI, – он становится точкой приложения сознательных, целенаправленных усилий. Даже если выполняются все требования, о которых речь шла выше (т.е. значения этого параметра объективны, достоверны, детальны, собраны «по всему спектру»…), показатели выполнения KPI отражают в первую очередь приложенные к этому усилия. Естественно, если сбор данных ведется лишь с целью оценки результативности и эффективности сотрудника, его поощрения или наказания, этого будет вполне достаточно. По большому счету, в этом случае важно даже не содержание KPI, но лишь процент их выполнения.

Однако если речь идет о сборе данных для целей аналитики как она понимается в этой статье, т.е. о том, чтобы сопоставить какие-то из доступных показателей рабочей деятельности с данными из других источников (например, с результатами прохождения психометрических инструментов), требования к данным ощутимо меняются. Гораздо полезнее и информативнее в этом случае будут показатели, не входящие в число собственно KPI, т.е. такие, достижение которых не было непосредственной целью или условием для получения каких-либо вознаграждений. В то же время, разумеется, необходимо убедиться, что эти показатели связаны с рабочей деятельностью и объективно отражают ее эффективность.

В этом контексте нельзя не упомянуть еще одну проблему – так называемый «эффект кобры», т.е. сосредоточенность на определенных целевых показателях без учета средств и способов, за счет которых они достигаются, а также возможных последствий, т.е. игнорирование того, что установленные цели сами по себе становятся стимулами, влияющими на поведение. (Название этого эффекта связано с легендарной историей о том, как британские колониальные власти в Индии решили бороться с распространением ядовитых змей и объявили, что за каждую голову кобры будут выдавать награду, а предприимчивые местные жители начали разводить змей специально для этой цели).

«Помимо прочего, это означает, что показатели, полезные для принятия решений на одном временном горизонте, нередко перестают быть информативными на другом», – уточняет Максим. Например, если компания определяет свою прибыль в текущем квартале как единственный значимый KPI, логичным будет отказаться от вложений в развитие продуктов. Однако совершенно очевидно, что такой подход может привести к катастрофическим проблемам в долгосрочной перспективе.

Как известно, в сфере корпоративного управления похожие рассуждения стали отправной точкой для развития идеи системы сбалансированных показателей (Balanced Scorecards) – набора взаимосвязанных и взаимозависимых целей и критериев эффективности, требующих равного внимания руководства и гарантирующих, что организация развивается по-настоящему устойчиво в долгосрочной перспективе. Что же касается аналитической задачи исследования пользы от тестирования, которой посвящена эта статья, здесь эти соображения подталкивают к выводу о том, что корректный выбор используемых параметров эффективности – того, что с точки зрения тестирования называют «внешними критериями», – остается одним из самых сложных вопросов, стоящих перед HR.

Точки опоры

Итак, данные собраны: как результаты тестирования, так и показатели реальной рабочей деятельности. Предстоит их сопоставить. Зачастую в описании этого процесса используется термин «корреляция», но это не означает, что собственно корреляционный анализ является единственным и/или заведомо оптимальным методом обработки данных. В зависимости от специфики задачи и данных, можно задействовать самые разные подходы и техники: регрессионный анализ, кластеризация, дисперсионный анализ и мн. др. «Выбирая метод, нужно отталкиваться от вопроса, который стоит перед HR, и помнить, что не существует такого статистического метода, который сможет ответить сразу на все вопросы», – обращает внимание Максим Пескин.

Условно можно выделить две группы задач, которым соответствуют разные методики и приемы: во-первых, поиск взаимосвязей между какими-либо параметрами и критериями (если вопрос поставлен так, уместнее будут техники корреляционного и регрессионного анализа), во-вторых, выделение и сравнение между собой определенных групп людей (для этого предназначены методы кластеризации и дисперсионного анализа). В любом случае, важно помнить о том, что сила выявленных взаимосвязей или устойчивость различий – а большая часть статистических методов фокусируются именно на этом – отнюдь не всегда означает, что обнаружен масштабный эффект, т.е. смещение одного параметра сопряжено со значительным изменением другого.

Например, высокое значение коэффициента корреляции показывает лишь, что рост одного фактора будет сопровождаться ростом другого, а снижение – снижением, но не говорит о том, в какой мере будет снижаться второй. Это можно увидеть с помощью регрессионного анализа или – еще нагляднее – путем сравнения средних по нескольким группам. «Впрочем, если приводятся только данные по средним, можно заподозрить, что и это неспроста: например, дело в том, что внутригрупповые различия гораздо больше межгрупповых. А это значит, что средние и их сравнение –чисто формальный прием, и в действительности взаимосвязи между выделенными факторами не играют большой роли», – добавляет Максим Пескин.

Кроме того, отнюдь не всегда обоснованно ожидание, что некая закономерность или взаимосвязь непременно будет линейной и неограниченной, то есть будет наблюдаться для любых значений рассматриваемых параметров. «Например, нередко какая-то способность оказывает сильное влияние в определенном диапазоне, а ниже или выше некоторого порога уже не будет играть существенной роли для эффективности, потому что там уже начинают вовлекаться другие факторы», – говорит Максим Пескин.

Наконец, вопрос надежности актуален и релевантен не только для психометрических инструментов оценки, но и для любого процесса и метода сбора данных. Стоит учитывать, что определенная ошибка измерения заведомо присуща как показателям эффективности работы, так и экспертным оценкам и рейтингам.

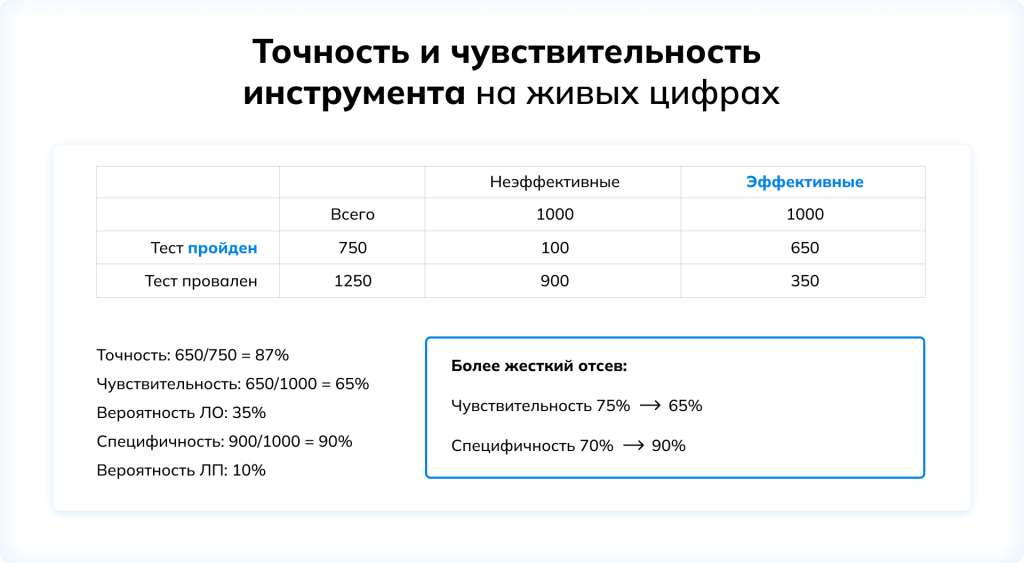

Помимо классических статистических подходов к анализу данных, позволяющих измерить пользу и эффект от тестирования, существуют и более простые методологии, которые позволяют сравнительно быстро и наглядно увидеть влияние инструмента и его связь с принимаемыми решениями. «Идея проста: после проведения оценки появляются два взаимосвязанных набора данных – что «говорит» тест и что существует в реальности. Задача аналитика – сопоставляя эти данные, определить оптимальную планку отсева, балансируя разные требования», – объясняет Максим Пескин. Исследователи анализируют соотношение 4 кластеров, в которые попадают результаты оценки: они могут быть истинно-положительными, истинно-отрицательными, ложно-положительными (успешное прохождение теста без успеха в «реальности») или ложно-отрицательными (соответственно, наоборот).

Прежде всего эти данные позволяют оценить два параметра. Во-первых, точность инструмента – это показатель, который отвечает на вопрос о том, насколько часто (с какой вероятностью) при положительном результате теста будет иметь место действительная эффективность в работе. Чувствительность теста, напротив, говорит о том, как часто (с какой вероятностью) действительно эффективный человек получит в тесте положительный результат. «Очевидно, идеальный инструмент должен быть и высокоточным, и сверхчувствительным, но в реальности это недостижимо, и приходится искать компромисс», – говорит Максим.

Итак, чтобы определить чувствительность и специфичность теста в определенных условиях, необходимо задать две «границы»: во-первых, отделить эффективных участников от неэффективных, во-вторых, установить планку отсева по результатам теста.

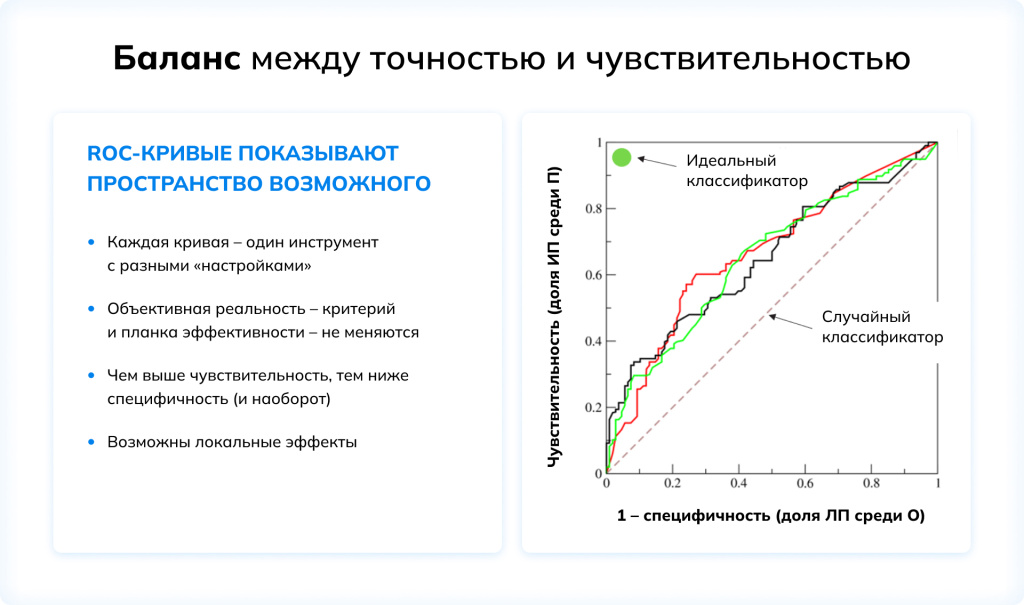

После этого можно сравнить последствия разных решений. Если сделать отбор более жестким, усложнив тест или повысив планку отсева, то вырастет специфичность инструмента – но его чувствительность упадет, и возрастет вероятность ложно-отрицательного результата для эффективных сотрудников. Если же, напротив, тест упростить или понизить планку отсева, эффект получится ровно противоположным. Это говорит о том, что невозможно одновременно избавиться от ложно-положительных и ложно-отрицательных результатов. «Можно увидеть результаты и текущий баланс, после чего необходимо будет принять решение: что в текущих обстоятельствах является более приоритетным, то есть, иначе говоря, ошибаться в какую сторону будет более предпочтительным», – говорит Максим.

Главной закономерностью, которая проступает при таком подходе к анализу данных, является обратная зависимость чувствительности и специфичности инструмента: чем выше один параметр, тем, соответственно, ниже будет другой. Оптимальное значение планки отсева для каждого инструмента будет соответствовать той точке на его графике, которая будет лежать ближе всего к левому верхнему углу (то есть идеальному классификатору) или, что то же самое, дальше всего от диагонали «случайного выбора». Проводя такие экспериментальные исследования и сравнивая между собой разные инструменты и методы оценки, нетрудно увидеть, что в некоторых случаях общее качество и точность отбора могут быть заметно увеличены буквально за счет смещения планки отсева – или, напротив, изменение планки отсева уже не даст ощутимой выгоды, и единственным рабочим решением остается замена инструмента.

Подведем итоги. Несмотря на все разнообразие концепций, подходов и методов, используемых при различных исследованиях пользы и выгоды от тестирования, основополагающую роль играет объективное качество инструментов оценки. Важно, чтобы тест или опросник был надежным и валидным: это фундаментальное требование. При этом экспериментальные доказательства всегда будут предпочтительнее и убедительнее любых экспертных мнений.

При подборе методов анализа важно отталкиваться от поставленных вопросов и стремиться расширять диапазон используемых техник и приемов. В бизнесе практически нет ничего фундаментально неизмеримого: все, что имеет значение, можно увидеть, а значит, определить и, в конечном счете, оценить. «Когда мы начинаем измерять эффективность какого-либо инструмента, пользу или выгоду от его применения, даже небольшое количество информации оказывается очень полезным: помогает снизить неопределенность, увидеть основные взаимосвязи и принять то или иное решение. И нередко оказывается так, что 20% возможных данных могут пролить свет на 80% возможных вопросов», – резюмирует Максим Пескин.

Данные облегчают принятие решений: это универсальный, объективный и общепринятый язык, помогающий найти ответы на важные вопросы бизнеса. Пользуясь достоверными, надежными и валидными инструментами, HR, безусловно, получают настоящую уверенность в решении стоящих перед ними задач. «Нет более простого, эффективного и надежного способа избавиться от сомнений, чем собрать настоящие данные», - говорит Максим.

Оставьте свои контактные данные и наш специалист свяжется с вами в ближайшее время.